Прекратить глубокое обучение

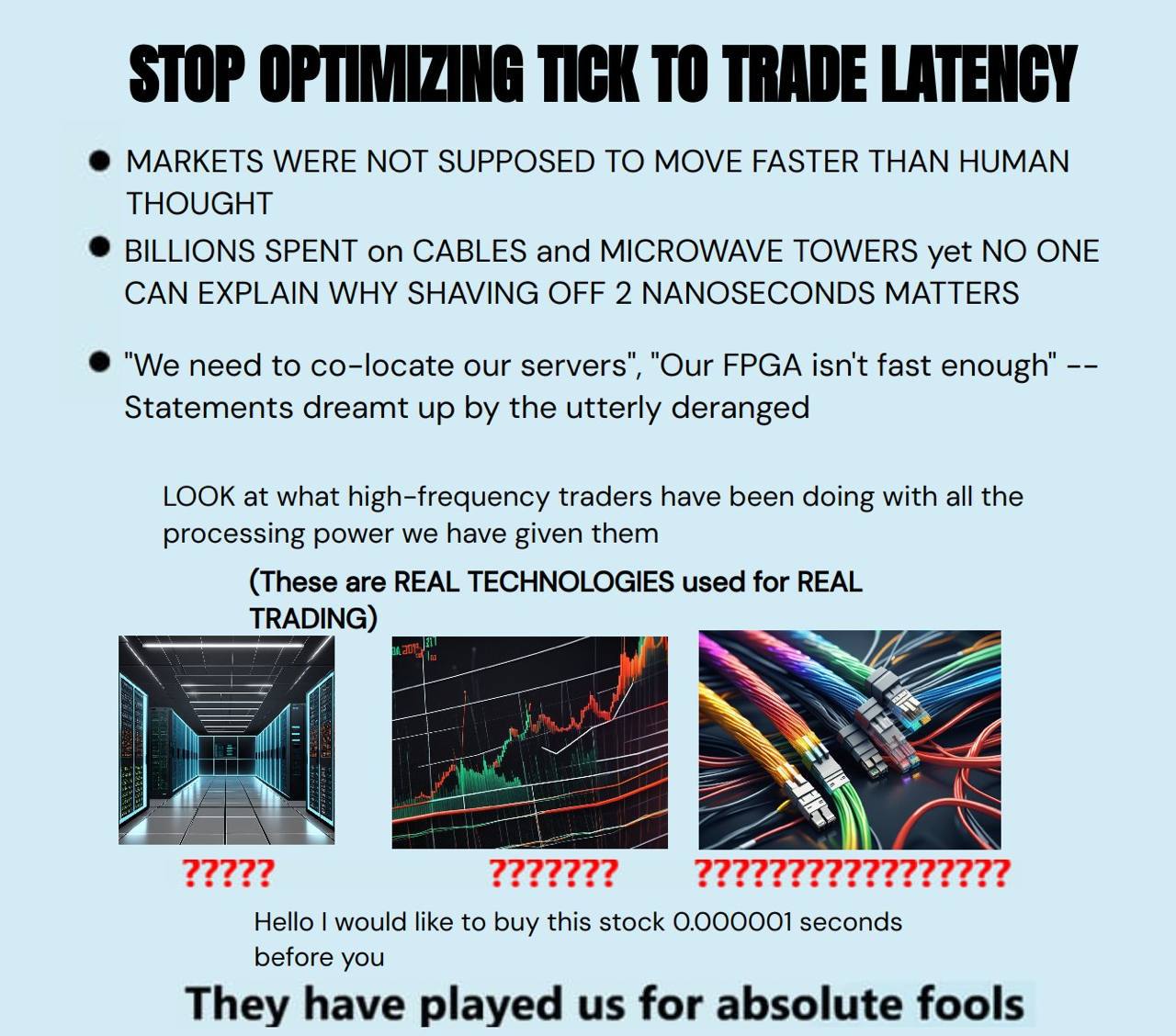

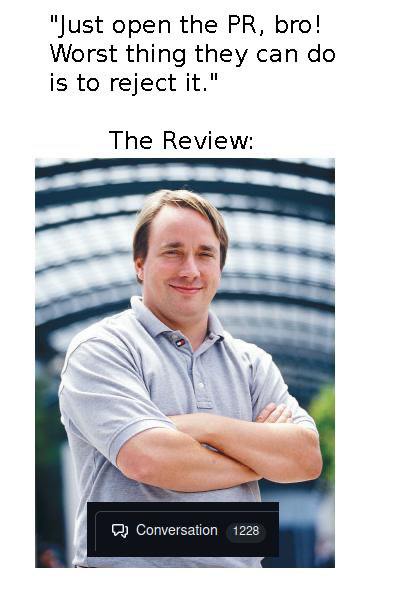

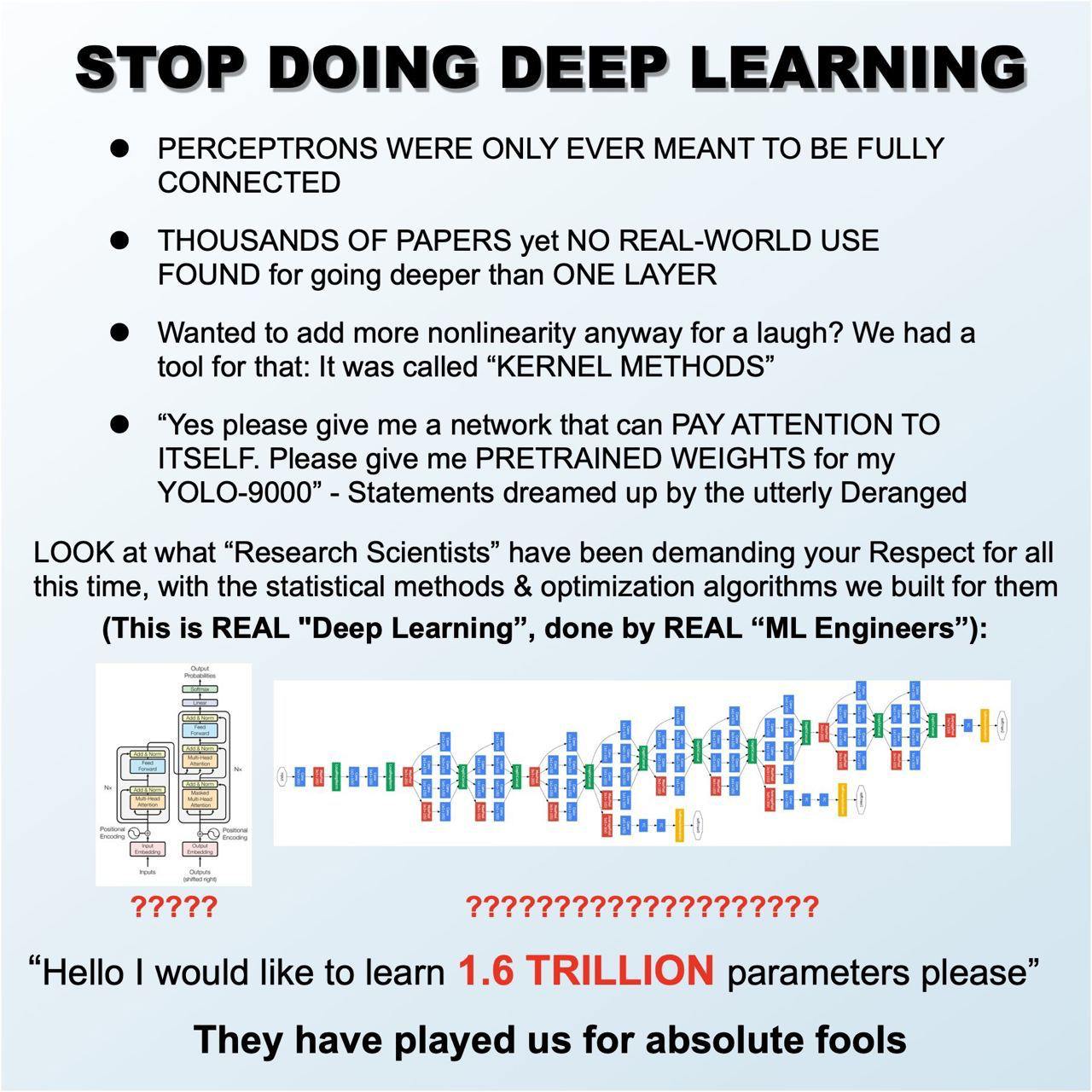

Этот мем критикует современное состояние глубокого обучения и подчеркивает ироничность его популярности среди исследователей. В верхней части изображены крупные черные буквы с призывом "ПРЕКРАТИТЬ ГЛУБОКОЕ ОБУЧЕНИЕ", за которыми следуют несколько пунктов с утверждениями о недостатках глубокого обучения. В мем включены такие утверждения, как "ПЕРЦЕПТРОНЫ ДОЛЖНЫ БЫТЬ ПОЛНОСТЬЮ СОЕДИНЕНЫ" и "ТЫСЯЧИ СТАТЕЙ, НО НИ ОДНОГО ПРАКТИЧЕСКОГО ПРИМЕНЕНИЯ ГЛУБЖЕ ОДНОГО СЛОЯ". В нижней части изображены две схемы, представляющие разные методы машинного обучения, а также фраза "ЭТО НАСТОЯЩЕЕ 'ГЛУБОКОЕ ОБУЧЕНИЕ', ВЫПОЛНЕННОЕ НАСТОЯЩИМИ 'ИНЖЕНЕРАМИ ПО МАШИННОМУ ОБУЧЕНИЮ" с явной насмешкой над современными исследованиями в области глубокого обучения. В заключение в мем добавлена фраза: "ОНИ ИГРАЛИ НАМИ КАК ЛОХАМИ".

Stop doing deep learning. Perceptrons were only ever meant to be fully connected. Thousands of papers yet no real-world use found for going deeper than one layer. Wanted to add more nonlinearity anyway for a laugh? We had a tool for that: It was called "Kernel methods." "Yes please give me a network that can pay attention to itself. Please give me pretrained weights for my YOLO-9000" - Statements dreamed up by the utterly Deranged. Look at what "research scientists" have been demanding your respect for all this time, with the statistical methods & optimization algorithms we built for them. (This is real "deep learning", done by real "ML engineers"). "Hello I would like to learn 1.6 trillion parameters please." They have played us for absolute fools.

Вы можете искать и отправлять мемы прямо в Telegram!

Просто введите в любом чате "@memexpertbot" и поисковой запрос - бот покажет наиболее подходящие мемы, и вы сможете сразу их отправить.